http://93.174.130.82/news/shownews.aspx?id=3ee5718a-2dc0-4857-b1c0-2fe90f872f7d&print=1

© 2025 Российская академия наук

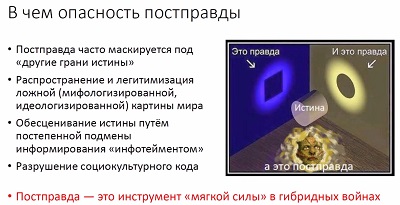

Искусственный интеллект (ИИ) может быть не только источником

новых рисков при его широком использовании, но и служить инструментом

обеспечения безопасности – не только компьютерных систем, но и общества в самом

широком гуманитарном смысле. Борьбе с так называемой постправдой был посвящен доклад

заведующего отделом Интеллектуальных систем ФИЦ «Информатика и управление» РАН,

профессора РАН Константина Воронцова на заседании президиума РАН по вопросам

безопасности ИИ 23 ноября 2021 г.

Постправда – это информационный поток, который намеренно

конструируется для создания виртуальной реальности с целью манипулирования

общественным сознанием. После брексита и избрания Трампа это слово стало

настолько популярным, что было признано Оксфордским словарем словом 2016 года.

«Речь о том, что IT-технологии немножечко вырвались из-под нашего контроля, –

рассказал Константин Воронцов. – Поисковые системы с их ранжированием – это ИИ.

Рекомендательные системы – это тоже ИИ. Это явления, которые в социуме

отражаются в виде информационных пузырей, появления ботоферм, которые имитируют

общественное мнение с не очень большими затратами ресурсов, распространение

фейков. С одной стороны, люди сами всю свою человеческую историю лгали и распространяли

слухи, а с другой стороны, технологии интенсифицировали эти явления так, что

это стало влиять на нашу безопасность. Причем ИИ, как технология, оказывается

по обе стороны баррикад и очень важно, чтобы наши технологии оказались, что

называется, на светлой стороне силы».

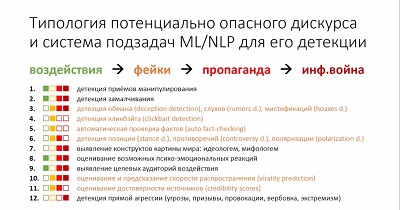

По словам Константина Воронцова, сейчас активно развиваются методы

обнаружения фейковых новостей, где выделяются семь четко формализованных задач,

которые уже достаточно надежно решаются с помощью ИИ: выявление обмана, автоматизация

проверки фактов, выявление позиции (точность выявления в новостях – 97%, а в Twitter –

68%), выявление полемики разногласий и поляризации общественного мнения (точность

73–83%), обнаружение противоречий между заголовком и текстом новости или иллюстрацией,

так называемые кликбейты (точность до 86%), оценка надежности источников

информации (точность до 81%).

«Эти задачи ИИ решает неплохо, но после всего этого

возникает некое ощущение неудовлетворенности, – говорит Константин Воронцов. – Специалисты

по большим данным ринулись на задачи обнаружения фейковых новостей буквально 5

лет назад – в 2016 году. Это видно по библиометрическим показателям. Буквально взорвались

темы постправды и фейковых новостей в академических исследованиях. Но чего-то

не хватает во всей этой структуре».

По словам Константина Воронцова, в западной литературе очень

аккуратно и политкорректно исследуются фейки в связи с тем, как они

распространяются в социальных сетях. А как же СМИ?

«А что – СМИ не лгут? СМИ не ведут по всему миру

информационные войны в интересах своих заказчиков? – спрашивает ученый. – Об

этом академическое сообщество на Западе пишет крайне мало. И почти не пишет в контексте

технологий ИИ. Об этом пишут люди, которые занимаются гуманитарными исследованиями.

Информационные войны – это достойная тема академических исследований на

протяжении нескольких десятилетий, но она не взрывалась в 2016 году.

Гуманитарии как исследовали эти эффекты, так и продолжают исследовать».

Приведенный выше слайд Константин Воронцов назвал главным в

своем докладе. На нем, кроме уже хорошо решаемых с помощью ИИ задач,

перечислены и те вопросы, которыми еще предстоит заняться.

По мнению Константина Воронцова, явно назрело объединение усилий

гуманитариев со специалистами в области ИИ. Современные модели ИИ пока

затронули только анализ фейков. Заняться СМИ им мешает то, что, когда дело

касается более сложных способов манипуляции общественным сознанием и приемов

информационной войны, возникают нетривиальные лингвистические конструкции,

которые требуют серьезной экспертизы со стороны гуманитариев – лингвистов,

политологов, журналистов, социологов, психологов.

«Мы хорошо понимаем, как решать эти задачи, если есть хорошо

сделанная разметка текстов, – объясняет суть проблемы Константин Воронцов. – И

получается так, что разметка текстов и мультимедйиных данных становится

магистральным способом формализации гуманитарных знаний для того, чтобы

технологии ИИ понимали естественный язык и в таких задачах».

Комментируя доклад Константина Воронцова, президент РАН

Александр Сергеев отметил важность затронутой проблемы.

«Общество постправды, в котором мы сейчас начинаем жить, опасно

не только с точки зрения национальной безопасности в каждой из стран, но и с точки

зрения устойчивости развития человечества, – подчеркнул Александр Сергеев. –

Представьте себе, что вся информация, которой располагают для принятия решений

управляющие органы, является, условно говоря, фейковой. Что за решения будут

приняты тогда? А сейчас фейковая информация приобретает все большие масштабы в

информационном поле. Это огромная угроза».